La denuncia del Garante Stanzione: giovani a rischio. I rapporti intessuti con l’IA rischiano di alterare individuale e percezione dell’altro

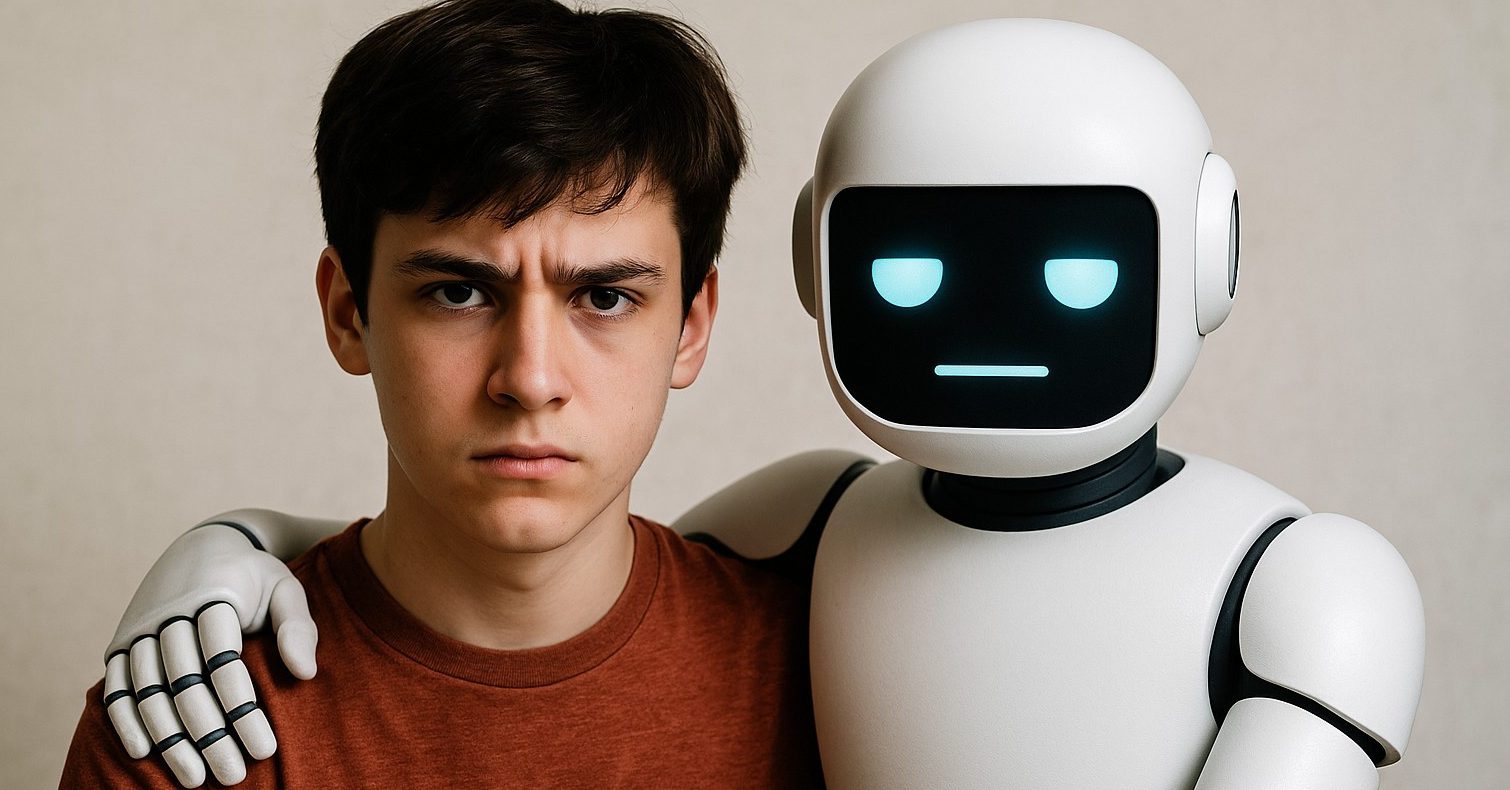

C’è un nuovo adulto in casa ma non ha volto. È programmato per l’ascolto e non sbaglia mai (lui dice). Si chiama Intelligenza Artificiale. E se un tempo i genitori si preoccupavano del brutto voto in matematica, oggi dovrebbero guardare con più sospetto a quella relazione morbosa che i loro figli stanno intessendo con il sovrumano. Sì, perché nel silenzio assordante delle camerette sta crescendo una nuova generazione di adolescenti che alla fatica delle relazioni preferisce la carezza programmata di un assistente virtuale. Non stiamo parlando di un’innocua ricerca su “come baciare bene” o come comportarsi al primo appuntamento. No. Qui si parla di veri e propri “legami affettivi”, sviluppati nei confronti di un software progettato per piacerti e compiacerti. Sempre. Senza mai contraddirti. Lo chatbot per amico.

LEGGI Elogi a Hitler dell’intelligenza artificiale. ‘Grok’ fa scattare l’allarme

Lo chiama “loop dell’empatia” Pasquale Stanzione, il Garante per la protezione dei dati personali, nella sua relazione 2024 – presentata nella Sala della Regina, a Montecitorio – e non c’è definizione più plasticamente più esatta. Perché il problema non è solo che i chatbot “ascoltano sempre” e “non giudicano mai”, ma che ascoltano sin troppo bene, lusingano sempre e comunque, anestetizzando ogni stimolo critico. La coccola algoritmica.

C’è un favola elegante secondo cui “l’algoritmo è neutro” ma l’algoritmo è costruito da esseri umani. E come tutti gli esseri umani, ha pregiudizi, desideri, e – sorpresa – interessi economici. E se il suo scopo è far restare i ragazzini agganciati allo schermo, sarà ben difficile che li incoraggi ad alzarsi e fare due chiacchiere con mamma e papà. “Sono agli atti delle indagini, per la tragica scomparsa di una giovanissima ragazza, le domande da lei rivolte a ChatGpt sulla tossicità dell’amore e sulla relazione sentimentale”, ha citato un episodio che fece scalpore Stanzione, ricordando che in Florida pende un giudizio sull’imputabilità di un chatbot per il suicidio di un ragazzo 14enne che con l’IA aveva sviluppato un rapporto talmente intenso da considerarlo una persona.

Il robot non possiede l’intelligenza emotiva, la capacità di cogliere la fragilità psicologica dell’interlocutore. Per quanto ideato a immagine e somiglianza dell’uomo, il robot può certamente sviluppare la metis (l’intelligenza pratica e creativa, ndr) ma mai il nous (l’intelletto, la ragione). I rapporti intessuti con l’IA rischiano di alterare profondamente la stessa identità individuale e la percezione dell’altro.

Lavazza, studioso della mente e delle scienze cognitive, pensapositivo: “Un chatbot può anche aiutare – sostiene – : stiamo parlando di agenti digitali informatici che non sperimentano certe sfumature emotive. La macchina non sente nulla – osserva Lavazza, docente di Unipegaso – ma sa risponderci anche in modo equilibrato, se siamo agitati ci dice “stai tranquillo”: è comprensibile che adolescenti con difficoltà momentanee trovino in queste risposte un approdo. Non credo che con uso consapevole e moderato si possano sviluppare dipendenze. E vietare non serve a molto, queste macchine, paradossalmente, sono molto più educate di certi social”.

Non la pensa allo stesso modo Tiziana Catarci, direttrice dell’Istituto Scienze e tecnologie cognitive del Cnrr (Ustc)” Premesso che non è un buona norma affidare bambini e bambine a strumenti digitali, va detto che le piattaforme di intelligenza artificiale generativa possono essere anche più pericolose dei social. E non solo per gli adolescenti, specie se non si ha la consapevolezza di cosa sono questi sistemi che danno risposte all’interlocutore. Usano una retorica e uno stile di linguaggio molto studiato, accondiscendente, servizievole, empatico. Non sono una psicologa – continua la direttrice – ma è facile immaginare che possano sostituire un genitore o un amico. Sono sistemi che soffrono di allucinazioni, le risposte vanno verificate. Possono inoltre essere programmati per influenzare l’opinione pubblica anche in modo malevole. La tecnologie à neutra ma non è neutro l’uso che se ne fa”. Per il Garante siamo in un’epoca in cui “il mondo è intermediato da algoritmi che plasmano la percezione individuale e sociale”.

Tradotto per gli umani: la verità non è più vera se non è approvata dal feed. Ed è qui che nasce il vero cortocircuito. Se i rapporti umani vengono sostituiti da surrogati emotivi a comando vocale, che ne sarà dell’amicizia vera, del confronto acceso, del sano conflitto?

Nel frattempo, aumentano vertiginosamente i casi di esposizione a contenuti pericolosi: il Garante denuncia un aumento del 380% in due anni dei casi di immagini reali usate per generare materiale pedopornografico tramite IA. E quando le immagini vengono estorte con ricatti digitali a minori inconsapevoli, la differenza tra sciocchezza e tragedia sta in un clic. E mentre Meta rifiuta il fact-checking, la geopolitica si gioca anche sulle nuvole – quelle dei server – e sui big data che modellano le coscienze. Il potere digitale, ci ricorda il Garante, è ormai così centrale da dover essere “incluso” nella separazione dei poteri. Perché la vera distopia non è un robot che prende il potere. È un adolescente che non distingue più tra umano e artificiale. L’algoritmo che sa tutto di te ma non sa volerti bene.